Wie kognitive Verzerrungen Sicherheitsentscheidungen sabotieren: Denken in Fallen

Trotz steigender Budgets für Cybersicherheit treffen selbst erfahrene IT-Experten systematische Fehlentscheidungen – nicht aus Unwissenheit, sondern wegen kognitiver Verzerrungen. Denn Ankereffekte, Gruppendenken oder die Kontrollillusion beeinflussen die Risikowahrnehmung, die Budgetplanung und strategische Weichenstellungen erheblich.

Wer langfristig resilient bleiben will, muss diese „Denkfallen“ gezielt adressieren: durch strukturierte Entscheidungsprozesse, heterogene Teams und eine Sicherheitskultur, die Widerspruch zulässt.

Die globalen Ausgaben für Cybersicherheit sollen laut IDC bis 2028 auf fast 400 Milliarden US-Dollar steigen, in Deutschland werden laut Branchenverband BITKOM bereits über zehn Milliarden Euro investiert.[2,7] Dennoch oder gerade deswegen professionalisieren sich Cyberkriminelle immer weiter: Sie agieren arbeitsteilig, hochspezialisiert und nutzen mit Cybercrime-asa-Service und künstlicher Intelligenz (KI) zunehmend industrielle Strukturen.[5,6] Das FBI schätzt, dass rund 90 Prozent aller cyberbezogenen Delikte nicht gemeldet werden.[9] Dieses Dunkelfeld verzerrt die Risikowahrnehmung erheblich und erschwert eine realistische Einschätzung der Bedrohungslage.

Während sich viele Investitionen auf technologische Aspekte konzentrieren, rückt der menschliche Faktor häufig in den Hintergrund – obwohl er eine zentrale Angriffsfläche darstellt. Die Wirksamkeit von Cybersicherheitsmaßnahmen hängt maßgeblich vom Verhalten der Menschen ab. Doch viele unterschätzen ihre eigene Verwundbarkeit und wiegen sich fälschlicherweise in Sicherheit.[1,10]

Selbst sogenannte „Digital Natives“ weisen oft hohe Defizite im Bewusstsein für Cyberrisiken auf. Es ist ein weitverbreiteter Irrglaube, dass ihre Technikaffinität auch mit höherer Sicherheitskompetenz einhergeht. Trotz erheblicher Investitionen in Schulungen zeigen viele Beschäftigte ein übersteigertes Vertrauen in die Fähigkeiten ihrer Organisation und ihre eigene Kompetenz zur Erkennung und Abwehr von Cyberangriffen.

Dabei beeinflussen systematische Denk- und Wahrnehmungsfehler die Entscheidungsfindung in hohem Maße. Die Wissenschaft hat inzwischen über 150 solcher Verzerrungen identifiziert, die Wahrnehmung, Informationsverarbeitung und Urteilsbildung erheblich beeinträchtigen können.[4] Selbst erfahrene IT- und Sicherheitsexperten sind anfällig für kognitive Verzerrungen, was zu materiellen Fehlentscheidungen führen kann. Im Folgenden werden einige dieser typischen Denkfallen näher vorgestellt.

Wenn Awareness-Kampagnen an ihre Grenzen stoßen

Als Reaktion auf die zunehmende Bedrohungslage setzen viele Organisationen auf Awareness-Kampagnen, um Mitarbeiter für Cyberrisiken zu sensibilisieren. In Schulungen, E-Learnings oder

simulierten Phishing-Tests sollen sie lernen, Bedrohungen frühzeitig zu erkennen und entsprechend zu handeln. Ziel ist es, eine „menschliche Firewall“ zu etablieren – ein kollektives Risikobewusstsein, das technische Schutzmechanismen ergänzt.

Das ist zunächst auch sinnvoll. In der Praxis bleiben die Erfolge jedoch leider oft hinter den Erwartungen zurück. Trotz regelmäßiger Trainings klicken Mitarbeiter weiterhin auf verdächtige Links, verwenden schwache Passwörter oder umgehen Sicherheitsrichtlinien.[3,13] Häufig wird dies als mangelnde Disziplin oder fehlendes Interesse ausgelegt – eine Sichtweise, die die tieferliegenden Ursachen verkennt.

Menschliches Verhalten folgt nicht ausschließlich rationalen Regeln. Entgegen dem normativen Idealbild der Volkswirtschaftslehre, das den Menschen als homo oeconomicus charakterisiert – also als ein rational handelndes Wesen, das immer darauf abzielt, seinen Nutzen zu maximieren – weiß die Forschung schon lange, dass Menschen keine rationalen Rechenmaschinen sind. Selbst gut informierte Personen handeln in kritischen Situationen häufig nicht so, wie es die Theorie erwarten lässt.

Diese Diskrepanz liegt nicht nur an fehlendem Wissen oder mangelnder Aufmerksamkeit, sondern auch an psychologischen Faktoren: Menschen unterliegen systematischen Denkfehlern, sogenannten kognitiven Verzerrungen. Sie wirken unbewusst, sind stabil und lassen sich nur schwer durch klassische Aufklärung beseitigen. Selbst wenn Menschen sich ihrer eigenen Schwächen bewusst sind, ändern sie deshalb nicht notwendigerweise ihr Verhalten. Oft bleibt man in gewohnten Mustern gefangen, auch wenn man deren Auswirkungen erkennt.

Damit geraten die besten Awareness-Maßnahmen an ihre Grenzen. Sie adressieren zwar das „Was“, aber zu selten das „Wie“ des Denkens. Auch Fach- und Führungskräfte sind nicht immun. Wer Cybersicherheit nachhaltig verbessern will, muss daher verstehen, wie Menschen tatsächlich Entscheidungen treffen – und warum sie dabei immer wieder in dieselben Fallen tappen.

Zwei Systeme des Denkens: Schnell versus langsam

In der psychologischen und verhaltensökonomischen Forschung wird zur Erklärung kognitiver Verzerrungen häufig auf die Duale Systemtheorie verwiesen und das von Daniel Kahneman[8] zusammengefasste Modell von zwei Denkmodi herangezogen (siehe auch Tabelle 1):

- ein schnelles, automatisiertes und erfahrungsbasiertes System („System 1“) sowie

- ein langsames, reflektiertes und analytisches System („System 2“).

Tabelle 1: Gegenüberstellung der Denkmodi nach Kahnemans Dualer Systemtheorie

Im Alltag verlassen wir uns oft auf System 1 für viele Entscheidungen. Das spart Zeit und Energie, hat jedoch seinen Preis. So wissen wir, ohne ernsthaft darüber nachzudenken, dass 2+2 = 4 ergibt oder dass London die Hauptstadt von Großbritannien ist. Im Umkehrschluss neigen wir dazu, selbst wenn eigentlich eine gründliche Analyse (System 2) notwendig wäre, unbewusst auf erlernte Muster zurückzugreifen.

Wir ziehen voreilige Schlüsse, lassen uns von oberflächlichen Reizen fehlleiten oder übersehen wichtige Details – einfach, weil unser Gehirn aus Effizienzgründen den konditionierten Abkürzungsweg 1 nimmt und sich den Aufwand spart, tiefer zu analysieren über den mühsamen Weg 2. Besonders unter Stress, Unsicherheit oder Zeitdruck gewinnen diese Automatismen an Einfluss.

Fünf zentrale Verzerrungen

Im Kontext der Cybersicherheit zeigen sich fünf typische Beispiele, die immer wieder zu suboptimalen Entscheidungen führen:

1. Affektheuristik:

Die Affektheuristik ist eine kognitive Verzerrung, bei der emotionale Reaktionen Entscheidungen stark beeinflussen. Anstatt rational zu entscheiden, verlassen sich Menschen oft unbewusst auf ihr Bauchgefühl, besonders bei komplexen Risiken. Die Frage „Wie fühle ich mich dabei?“ ersetzt die anspruchsvollere „Was halte ich objektiv davon?“.

In der Cybersicherheit zeigt sich dies bei der Wahl von Cybersicherheitsanbietern, wo persönliche Sympathie oder ein überzeugendes Auftreten zu voreiligen Entscheidungen führen können. Bei der Angebotspräsentation beispielsweise wird dann der Eindruck der präsentierenden Personen überbewertet, obwohl sie üblicherweise weder für die Produktentwicklung noch den späteren Betrieb verantwortlich sind und sich aus der Präsentation keine Ableitungen auf die Produktqualität vornehmen lassen. Das geht zum Teil einher mit dem sogenannten Halo-Effekt (Heiligenschein), wonach bekannten Anbietern oft voreilig Vertrauen geschenkt wird, nicht aufgrund objektiver Überlegenheit, sondern aus Unsicherheit und dem Wunsch, Fehler zu vermeiden („Nobody ever got fired for buying IBM“).

2. Ankereffekt:

Dieser Effekt stellt eine kognitive Verzerrung dar, bei der externe Informationen als fester Bezugspunkt (Anker) für nachfolgende Entscheidungen fungieren. Besonders bekannt ist dieses Phänomen in den Finanzmärkten, wo Personen bei Schätzungen oder Prognosen häufig von einem Anfangswert ausgehen und ihre Einschätzungen nur unzureichend anpassen. Zahlen und Statistiken wirken oft ebenfalls als Anker und treten beispielsweise in Verbindung mit der sogenannten Regressionsverzerrung auf, bei der irrtümlicherweise die Diskussion von einem falschen Basiswert aus startet.

Im Kontext der Cybersicherheit können fehlerhaft ermittelte Schätzungen der Kosten eines Systemausfalls die Risikowahrnehmung und die darauf basierenden Entscheidungen erheblich verzerren. Werden solche Werte als „Fakten“ präsentiert, haben sie nachhaltige Auswirkungen auf Budgetplanungen und Ressourcenzuweisungen. Studien zeigen, dass etwa ein Drittel der Unternehmen die Eintrittswahrscheinlichkeit und die Auswirkungen von Cyberrisiken nicht angemessen bewerten kann. Dennoch werden diese unsicheren Werte als Anker verwendet, was die Investitionsentscheidungen erheblich verfälscht.

3. Gruppendenken:

Hierbei handelt es sich um ein soziales Phänomen, bei dem der Wunsch nach Harmonie in einer Gruppe so stark ist, dass abweichende Meinungen unterdrückt werden. Selbst kompetente Personen passen sich oft der Gruppenmeinung an, nicht aus Überzeugung, sondern aus Angst vor sozialer Ablehnung. Diese „falsche“ Einigkeit führt dazu, dass kritische Aspekte übersehen und Risiken falsch eingeschätzt werden. Besonders in der Cybersicherheit kann Gruppendenken gravierende Folgen haben.

Wenn Sicherheitsrisiken oder Notfallmaßnahmen besprochen werden, bleiben alternative Sichtweisen oft ungehört, besonders wenn Mitglieder sich unsicher fühlen, ihre Meinung zu äußern. Dominante Meinungen können die Diskussion lenken, während stillschweigende Übereinstimmung als kollektives Urteil missverstanden wird. Das führt zu Echokammern, in denen bekannte Narrative verstärkt und neue Ideen unterdrückt werden, wodurch Warnsignale übersehen und fragwürdige Entscheidungen getroffen werden.

4. Kontrollillusion:

Das Fehlen von Sicherheitsvorfällen wird oft fälschlicherweise als Beweis für Sicherheit angesehen. Ein nicht erfolgter – oder schlimmstenfalls nicht erkannter – Cyberangriff wird als Zeichen für Kontrolle missinterpretiert. Zudem gibt es psychologische Hürden: Cybersicherheit bringt selten direkte finanzielle Erträge, was Investitionsentscheidungen erschwert. Entscheidungsträger sind darauf konditioniert, einen „Business Case“ zu präsentieren, der im präventiven Bereich oft schwer zu erstellen ist.

Ähnlich wie bei staatlichen Rüstungsausgaben entsteht auch in der Privatwirtschaft eine Legitimationslücke bei Investitionen in Cybersicherheit: Der Erfolg zeigt sich im besten Fall darin, dass nichts passiert, was die Rechtfertigung gegenüber Stakeholdern erheblich erschwert. Gerade in wirtschaftlich schwierigen Zeiten kann das dazu führen, dass Einsparungen zu schnell an kritischen Stellen vorgenommen werden.

5. Status-quo-Verzerrung:

Beim Treffen von Entscheidungen tendieren Menschen dazu, den Status quo zu bevorzugen – also den gegenwärtigen Zustand aufrechtzuerhalten, auch wenn es rational keine eindeutige Rechtfertigung dafür gibt. Es herrscht eine gewisse Resistenz gegenüber Veränderungen, denn Veränderungen bedeuten Risiken und könnten die Betriebsstabilität gefährden. IT-Teams halten daher lange an bewährten und lieb gewonnenen Systemen fest, was durch Sprichworte wie „Never change a running system“ verdeutlicht wird.

Die sogenannten Switching Costs – also die mit einem Systemwechsel verbundenen finanziellen, organisatorischen und psychologischen Aufwände – wie Migration und Einarbeitungszeiten verstärken diese Zurückhaltung. Zudem spielt die Verlustaversion eine große Rolle: Menschen bewerten potenzielle Verluste höher als Gewinne, was dazu führt, dass das Risiko durch Veränderungen überbewertet und die Vorteile unterbewertet werden. So bleibt man oft bei suboptimalen, aber vertrauten Lösungen, getrieben von dem Wunsch nach Stabilität und Risikovermeidung.

Wechselseitige Verstärkung

Die Forschung zu kognitiven Verzerrungen zeigt, dass sie oft in Kombination auftreten und sich gegenseitig verstärken.[11,12] Viele Studien betrachten Verzerrungen isoliert, doch die verhaltensökonomische und psychologische Forschung betont, dass sie in einem komplexen „kognitiven Ökosystem“ operieren, wo sie sich wechselseitig beeinflussen und in bestimmten Situationen synergetisch wirken.

In organisatorischen Entscheidungskontexten wird dies besonders deutlich, da mehrere Faktoren gleichzeitig interagieren. In dem Fall ist von kognitiven Interferenzen oder Bias-Clustern die Rede. Beispielsweise kann die Status-quo-Verzerrung durch Verlustaversion verstärkt werden, während Ankereffekte und Affektheuristiken die Wahrnehmung von Risiken und Chancen verzerren.

Gruppendenken kann zudem verhindern, dass diese Verzerrungen erkannt werden, was zu falschen Entscheidungen und ineffektiven Sicherheitsmaßnahmen führt. Daher ist es wichtig, Verzerrungen nicht isoliert zu betrachten, sondern ihr Zusammenspiel zu verstehen, um effektive Strategien zur Risikominimierung und Verhaltensänderung zu entwickeln.

Strukturierte Gegenmaßnahmen für die Praxis

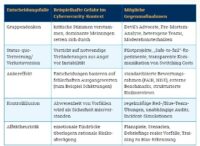

Kognitive Verzerrungen sind allgegenwärtig. Um deren negativen Auswirkungen in der Cybersicherheit wirksam zu verringern, müssen Organisationen über klassische Awareness-Kampagnen hinausgehen. Die folgenden Maßnahmen können helfen, menschliche Fehlentscheidungen zu minimieren und die Sicherheitskultur nachhaltig zu stärken (siehe auch Tabelle 2):

- Förderung einer Kultur der kritischen Reflexion und der offenen Kommunikation: Teams müssen möglichst divers sein und ermutigt werden, Risiken offen und ohne Angst vor Repressalien zu diskutieren. Nur in einem Klima, in dem viele verschiedene Erfahrungshintergründe und auch kritische Meinungen explizit willkommen sind, können Warnsignale frühzeitig geäußert werden. Teams können Entscheidungsprozesse aktiv strukturieren – etwa durch „Devil’s Advocate“-Rollen, in denen gezielt Gegenpositionen vertreten werden, oder durch „Pre-Mortem“-Analysen, die mögliche Fehlentscheidungen vorwegnehmen und deren Ursachen sichtbar machen. So lassen sich Gruppendenken vorbeugen und blinde Flecken frühzeitig erkennen.

- Systematische Berücksichtigung von Switching Costs und Verlustaversion: Führungskräfte sollten Veränderungen transparent kommunizieren und die damit verbundenen Risiken sowie Kosten realistisch abwägen. Schulungen, Pilotphasen und redundante Systeme erleichtern den Übergang und verringern die Angst vor Verlusten.

- Etablierung von Entscheidungshilfen und Checklisten: Verantwortliche sollten Entscheidungen – besonders zur Cybersicherheitsstrategie – nicht spontan oder unter Zeitdruck treffen. Notfallpläne für verschiedene Szenarien und standardisierte Bewertungsinstrumente fördern eine objektive Analyse von Risiken und Optionen und reduzieren kognitive Verzerrungen. Checklisten und Entscheidungsbäume minimieren emotionale Einflüsse und stellen rationale Kriterien in den Vordergrund. Kennzahlen und Metriken geben zusätzliche Orientierung.

- Multiperspektivische Entscheidungsfindung fördern: Unterschiedliche Experten und Abteilungen sollten frühzeitig eingebunden werden, um ein möglichst umfassendes Bild der Risiken und Lösungen zu erhalten. Zudem sind heterogen besetzte, interdisziplinäre Teams weniger anfällig für Gruppendenken: Vielfalt reduziert kollektive Verzerrungen und erweitert den Blick auf potenzielle Bedrohungen.

- Kontinuierliche Weiterbildung mit Fokus auf kognitive Verzerrungen: Fach- und Führungskräfte sollten gezielt für typische Denkfehler sensibilisiert werden. Schulungen sollten nicht nur technische Inhalte wiederholen, sondern Verhaltensreflexion und Perspektivenwechsel fördern – etwa durch Szenarien, Rollenspiele oder Debriefings realer Vorfälle.

- Einbindung externer Experten und Audits: Unabhängige Reviews durch Dritte decken blinde Flecken auf, die intern durch Verzerrungen oft unbemerkt bleiben. Externe Bewertungen ermöglichen eine realistischere Einschätzung der Cyberrisiken und stärken zugleich die Governance.

Tabelle 2: Häufige kognitive Verzerrungen im Sicherheitskontext und passende Gegenstrategien

Fazit

Cyberresilienz umfasst weit mehr als nur die technischen Aspekte. Da kognitive Verzerrungen auch Fach- und Führungskräfte der IT-Sicherheit beeinflussen, drohen Fehlentscheidungen selbst dort, wo Wissen und Erfahrung vorhanden sind. Wer nachhaltige Resilienz aufbauen will, muss daher die menschliche Komponente systematisch adressieren.

Die in diesem Beitrag beschriebenen Stolperfallen – von Gruppendenken über Ankereffekte bis hin zur Kontrollillusion – zeigen, wie leicht strategische Entscheidungen verzerrt werden können. Daraus folgt, dass Organisationen gezielt Gegenmaßnahmen etablieren sollten: strukturierte Entscheidungsprotokolle gegen Anker- und Status-quo-Effekte, Devil’s-Advocate-Rollen und Pre-Mortems gegen Gruppendenken, Red-/Blue-Team-Übungen gegen Kontrollillusion sowie Szenarien und Rollenspiele zur Sensibilisierung für affektgetriebene Fehlurteile.

Wesentlich ist, diese Verfahren nicht einmalig einzuführen, sondern regelmäßig zu überprüfen und an die dynamische Bedrohungslandschaft anzupassen. So wird das Auftreten der Denkmuster nicht nur erkannt, sondern minimiert – und aus einer potenziellen Schwäche entsteht organisatorische Stärke.

Angesichts stetig wachsender Cyberbedrohungen ist es unerlässlich, die Auseinandersetzung mit kognitiven Verzerrungen als festen Bestandteil der Cyberresilienz-Strategie zu verankern. Nur wenn die menschliche Dimension ebenso konsequent wie die technische adressiert wird, lassen sich Fehlentscheidungen vermeiden, Schutzmaßnahmen effektiv gestalten und Risiken unter Kontrolle halten. Die Sicherheit von morgen beginnt mit den Entscheidungen von heute – und mit der Fähigkeit, die eigenen Denkfallen zu überwinden.

Literatur

[1] Alnifie, K. M., & Kim, C. (2023). Appraising the Manifestation of Optimism Bias and Its Impact on Human Perception of Cyber Security: A Meta Analysis. Journal of Information Security, 14(2), 93–110. https://doi.org/10.4236/JIS.2023.142007

[2] BITKOM. (2024, 23. Oktober 2024). Erstmals mehr als 10 Milliarden Euro für Deutschlands Cybersicherheit https://www.bitkom.org/Presse/Presseinformation/Erstmals-mehr-als-10-Milliarden-Euro-fuer-Deutschlands-Cybersicherheit

[3] Candrick, W., Addiscott, R., Walls, A., & Michaels, A. (2023). Security Awareness Efforts Fall Short! Now What? (Survey Results Analysis). Gartner.

[4] Dimara, E., Franconeri, S., Plaisant, C., Bezerianos, A., & Dragicevic, P. (2018). A task-based taxonomy of cognitive biases for information visualization. IEEE transactions on visualization and computer graphics, 26(2), 1413–1432.

[5] Huang, K., & Madnick, M. S. S. (2017). Cybercrime-as-a-Service: Identifying Control Points to Disrupt.

[6] Huang, K., Siegel, M., & Madnick, S. (2018). Systematically Understanding the Cyber Attack Business: A Survey. ACM Comput. Surv., 51(4), Article 70. https://doi.org/10.1145/3199674

[7] IDC. (2025). Worldwide Security Spending to Increase by 12.2% in 2025 as Global Cyberthreats Rise, Says IDC. Retrieved Jul 16, 2025 from https://my.idc.com/getdoc.jsp?containerId=prEUR253264525

[8] Kahneman, D. (2011). Thinking, fast and slow. Farrar, Strau and Giroux.

[9] Mehta, I. (2019). The Need for Better Metrics on Cybercrime. http://www.jstor.com/stable/resrep20149

[10] Triplett, W. J. (2022). Addressing Human Factors in Cybersecurity Leadership. Journal of Cybersecurity and Privacy, 2(3), 573–586. https://doi.org/10.3390/jcp2030029

[11] Tversky, A., & Kahneman, D. (1974). Judgment Under Uncertainty: Heuristics and Biases. Science, 185(4157), 1124–1131.

[12] Tversky, A., & Kahneman, D. (1979). Prospect Theory: An Analysis of Decision under Risk. Econometrica, 47(2), 263–291. https://doi.org/10.2307/1914185

[13] Zwilling, M., Klien, G., Lesjak, D., Wiechetek, Ł., Cetin, F., & Basim, H. N. (2022). Cyber Security Awareness, Knowledge and Behavior: A Comparative Study. Journal of Computer Information Systems, 62(1), 82–97. https://doi.org/10.1080/08874417.2020.1712269

Dr. Marc Wilczek ist Technologie-Manager mit über 20 Jahren Erfahrung in Cybersicherheit, Cloud und digitaler Transformation. Zudem engagiert er sich zu diesen Themen in Forschung und Lehre und publiziert regelmäßig – so unter anderem auch in Kooperation mit dem Institut für Internet-Sicherheit – if(is).

Ralph Noll ist Cybersicherheitsexperte mit über 28 Jahren Erfahrung bei Professional Services Firmen. In seiner Karriere hat er Teams im Bereich Digitale Forensik geleitet, um digitale Spuren in IT-Systemen forensisch aufzuklären, sowie ein Cyber Incident Response Team bei Deloitte aufgebaut und geleitet, das Unternehmen bei der Abwehr und Analyse von Cyberangriffen unterstützt.

Norbert Pohlmann ist Professor für Cybersicherheit und Leiter des Instituts für Internet-Sicherheit – if(is) an der Westfälischen Hochschule in Gelsenkirchen sowie Vorstandsvorsitzender des Bundesverbands IT-Sicherheit – TeleTrusT und im Vorstand des Internetverbandes – eco.

Newsletter Abonnieren

Abonnieren Sie jetzt IT-SICHERHEIT News und erhalten Sie alle 14 Tage aktuelle News, Fachbeiträge, exklusive Einladungen zu kostenlosen Webinaren und hilfreiche Downloads.